Как игроку максимизировать выигрыш в ряде игровых автоматов? Это послужило источником вдохновения для “задачи о многоруком бандите”, распространенной задачи в обучении с подкреплением, в которой “агенты” делают выбор, чтобы получить вознаграждение. Недавно международная исследовательская группа во главе с Хироаки Синкавой из Токийского университета разработала расширенную схему обучения с фотонным подкреплением, которая позволяет перейти от статической задачи о бандитах к более сложной динамической среде. Это исследование было опубликовано в журнале Intelligent Computing.

Успех этой схемы зависит как от фотонной системы для повышения качества обучения, так и от поддерживающего алгоритма. Рассматривая “потенциальную фотонную реализацию”, авторы разработали модифицированный алгоритм Q-обучения bandit и подтвердили его эффективность с помощью численного моделирования.

Они также протестировали свой алгоритм с параллельной архитектурой, где одновременно работают несколько агентов, и обнаружили, что ключом к ускорению процесса параллельного обучения является избежание противоречивых решений за счет использования преимуществ квантовой интерференции фотонов.

Хотя использование квантовой интерференции фотонов не ново в этой области, авторы полагают, что это исследование является “первым, которое связывает понятие фотонного совместного принятия решений с Q-обучением и применяет его к динамической среде”. Задачи обучения с подкреплением обычно ставятся в динамической среде, которая меняется в зависимости от действий агентов, и, таким образом, являются более сложными, чем статическая среда в задаче о бандитах.

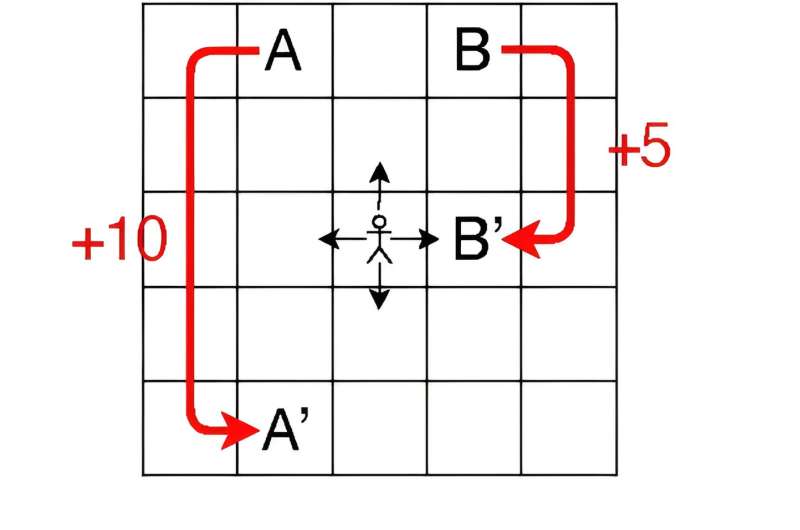

Это исследование нацелено на мир сетки, представляющий собой набор ячеек, содержащих различные вознаграждения. Каждый агент может двигаться вверх, вниз, влево или вправо и получать вознаграждение в зависимости от своего текущего перемещения и местоположения. В этой среде следующий шаг агента полностью определяется его текущим перемещением и местоположением.

В моделировании в этом исследовании используется сетка размером 5 × 5 ячеек; каждая ячейка называется “состоянием”, каждое движение, совершаемое агентом на каждом временном шаге, называется “действием”, а правило, определяющее, как агент выбирает определенное действие в каждом состоянии, называется “политикой”. Процесс принятия решений спроектирован как сценарий задачи о бандитах, где каждая пара состояние-действие рассматривается как игровой автомат, а изменения значения Q – значений пар состояние—действие – рассматриваются как вознаграждение.

В отличие от базовых алгоритмов Q-обучения, которые обычно фокусируются на поиске оптимального пути для максимизации вознаграждения, модифицированный алгоритм Q-обучения bandit нацелен на эффективное и точное определение оптимального значения Q для каждой пары состояние-действие во всей среде.

Следовательно, агенту важно соблюдать хороший баланс между “использованием” знакомых пар с высокими значениями для более быстрого обучения и “исследованием” нечастых пар для получения потенциально более высоких значений. В качестве политики используется алгоритм softmax, популярная модель, которая отлично справляется с такого рода балансировкой.

Будущим приоритетом авторов является разработка фотонной системы, поддерживающей бесконфликтное принятие решений по крайней мере тремя агентами, в надежде, что ее добавление к предложенной ими схеме поможет агентам избежать принятия противоречивых решений. Тем временем они планируют разработать алгоритмы, которые позволят агентам действовать непрерывно, и применить свой алгоритм Q-обучения bandit к более сложным задачам обучения с подкреплением.